KI-Agenten erklärt: Chancen, Risiken und Business Use Cases

Kaum ein aktueller Bericht über Künstliche Intelligenz kommt ohne Begriffe wie Agenten, KI-Agenten oder Agentic AI aus. Die Suchtrends zu diesem Thema haben sich seit Ende 2024 vervielfacht, und praktisch jeder große Tech-Konzern hat seit Jahresbeginn eigene Frameworks oder Plattformen vorgestellt, von OpenAI über Google bis hin zu Meta.

Laut einer aktuellen Gartner-Studie beschäftigen sich immer mehr Unternehmen mit Agentic AI – gleichzeitig prognostizieren die Analysten, dass über 40 % dieser Projekte bis 2027 scheitern könnten (Gartner 2025). Dieses Spannungsfeld verdeutlicht: Agentic AI ist mehr als eine kurzfristige Modeerscheinung. Gleichzeitig bleibt jedoch die Frage offen: Handelt es sich um eine echte technologische Revolution oder am Ende doch nur um den nächsten Hype, der bald wieder abflacht?

Welche Aufgaben können KI-Agenten tatsächlich übernehmen und wo liegen ihre Grenzen?

Diese Fragen sind nicht nur für Technologiebegeisterte spannend. Auch für Unternehmen aller Branchen stellt sich zunehmend die praktische Frage: Wie lassen sich KI-Agenten sinnvoll im Geschäftsalltag einsetzen, um Prozesse zu automatisieren, Entscheidungen zu beschleunigen oder Wissen effizienter nutzbar zu machen, ohne dabei Kontrolle, Transparenz oder Sicherheit zu verlieren?

In den folgenden Abschnitten werfen wir deshalb einen genaueren Blick auf das Konzept der KI-Agenten: was sie sind, warum sie gerade jetzt so relevant werden, welche technischen Grundlagen dahinterstehen und wo sich bereits heute konkrete Anwendungsfälle finden lassen. Außerdem gehen wir auf die Herausforderungen ein, die mit autonomen KI-Systemen einhergehen, von technischen Risiken über rechtliche Fragen bis hin zu ethischen Überlegungen.

Am Ende soll deutlich werden: Zwischen Science-Fiction und realer Effizienzsteigerung liegt bei KI-Agenten nur ein schmaler Grat und wer ihn versteht, kann aus dem Hype echten geschäftlichen Nutzen ziehen.

Gartner, Inc. (2025). Gartner predicts over 40 percent of agentic AI projects will be canceled by end of 2027.

- 13. Oktober. 2025

Karin Schnedlitz

Content Marketing Managerin

2. Was sind KI-Agenten (Agentic AI)?

Definition & Funktionsweise von KI-Agenten

Ein KI-Agent ist ein System, das seine Umgebung wahrnimmt, eigenständig Entscheidungen trifft und gezielt handelt, um ein bestimmtes Ziel zu erreichen. Diese drei Schritte, wahrnehmen, entscheiden, handeln, bilden den Kern jedes agentischen Systems.

Beispiele aus Alltag und Business

So abstrakt das zunächst klingt, so alltäglich ist das Prinzip. Ein einfaches Beispiel:

Ein gewöhnliches Thermostat misst die aktuelle Raumtemperatur (es nimmt seine Umgebung wahr), vergleicht sie mit dem gewünschten Sollwert (es entscheidet) und öffnet oder schließt das Heizventil, um die Temperatur anzupassen (es handelt). Damit erfüllt es genau die drei Grundprinzipien eines KI-Agenten, wenn auch in einer sehr einfachen Form.

Ein KI-Agent arbeitet also immer auf ein bestimmtes Ziel hin, das ihm in der Regel ein Mensch vorgibt. Dieses Ziel kann ganz unterschiedlich aussehen:

- Ein selbstfahrendes Auto soll einen Zielort sicher erreichen.

- Ein digitaler Assistent soll einen gemeinsamen Termin für mehrere Personen finden.

- Ein Einkaufsagent soll automatisch Bestellungen auslösen, wenn der Lagerbestand sinkt.

Um das Ziel zu erreichen, „beobachtet“ der KI-Agent seine Umgebung, entweder physisch (wie ein Roboter mit Sensoren und Kameras) oder digital (etwa durch den Zugriff auf Dateien, Kalender, E-Mails oder Datenbanken). Anschließend vergleicht er den aktuellen Zustand mit dem gewünschten Zielzustand und wählt eigenständig die nächsten Schritte aus.

Dieser Prozess wiederholt sich fortlaufend: Wahrnehmung, Bewertung, Handlung und wieder von vorn. Mit jeder Schleife nähert sich der Agent seinem Ziel an. Im Beispiel des selbstfahrenden Autos bedeutet das, Meter für Meter weiterzufahren, bis der Zielort erreicht ist. In der digitalen Welt heißt es, Terminkalender abzugleichen, freie Zeitfenster zu finden und automatisch Einladungen zu verschicken.

Das Funktionsprinzip erinnert stark an menschliches Problemlösen und genau das war auch die ursprüngliche Idee hinter dem Konzept. Bereits in den 1950er-Jahren beschrieben Forscher in der klassischen KI-Forschung sogenannte agentische Systeme: technische Einheiten, die ähnlich wie Menschen Informationen aufnehmen, bewerten und danach handeln.

Moderne KI-Agenten knüpfen an diese Idee an, gehen aber weit darüber hinaus. Dank neuer Technologien können sie komplexe Umgebungen analysieren, flexibel auf Veränderungen reagieren und aus bisherigen Handlungen lernen. Damit sind sie nicht mehr nur simple Regelautomaten, sondern zunehmend vielseitige, digitale Akteure, die eigenständig Aufgaben übernehmen.

In der aktuellen Forschung wird jedoch darauf hingewiesen, dass der Begriff „Agentic AI“ teilweise eine alte Idee neu verpackt. Wie Botti (2025) in der Studie ‘Agentic AI and Multiagentic: Are We Reinventing the Wheel?’ betont, besteht die Gefahr, beim Hype-Begriff „Agentic AI“ klassische Konzepte der Agenten- und Multiagentenforschung (etwa aus den Arbeiten von Wooldridge, Jennings etc.) zu übersehen. Diese historische Perspektive hilft, neue Entwicklungen kritisch einzuordnen – und zeigt, dass moderne Agenten nicht aus dem Nichts entstanden sind, sondern Teil einer langen Forschungstradition.

Botti, V. (2025). Agentic AI and Multiagentic: Are We Reinventing the Wheel?

3. LLM-KI-Agenten – warum Sprachmodelle den Unterschied machen

Von klassischen Agenten zu autonomen Systemen

Doch wenn es KI-Agenten schon seit Jahrzehnten gibt, warum erleben sie gerade jetzt einen solchen Hype? Die Antwort liegt in einer anderen bahnbrechenden Entwicklung der letzten Jahre: den Large Language Models (LLMs).

Wie das Fraunhofer IESE (Siebert & Kelbert, 2024) erklärt, beruht ihre Stärke auf einer speziellen Architektur: Sprache wird in Token zerlegt, in semantische Vektoren übersetzt und mithilfe von Wahrscheinlichkeiten weiterverarbeitet. Genau dadurch erhalten KI-Agenten jene Flexibilität, die sie heute zu leistungsfähigen digitalen Akteuren macht.

Sprachmodelle, die hinter ChatGPT oder MyGPT stecken, haben die Art und Weise revolutioniert, wie Computer mit Menschen interagieren. Zum ersten Mal können Maschinen nicht nur Sprache verstehen und erzeugen, sondern auch komplexe Zusammenhänge analysieren, Anweisungen interpretieren und Schlussfolgerungen ziehen, um daraus Handlungen abzuleiten.

Frühere Agenten mussten jede mögliche Situation mühsam programmiert oder aufwendig trainiert werden. Einfache Regelwerke bestimmten, wie ein System auf eine bestimmte Eingabe reagieren sollte. Dadurch waren klassische Agenten sehr spezialisiert – zuverlässig in klar definierten Szenarien, aber kaum anpassungsfähig.

Siebert, J., & Kelbert, P. (2024, 17. Juni). Wie funktionieren LLMs? Ein Blick ins Innere großer Sprachmodelle. Fraunhofer IESE

LLMs als „Gehirn“ moderner KI-Agenten

LLMs haben diese Einschränkungen weitgehend aufgehoben. Sie sind auf riesigen Datenmengen trainiert und können dadurch Muster, Bedeutungen und Beziehungen zwischen Konzepten erkennen. Mit nur wenigen zusätzlichen Anweisungen („Prompts“) sind sie in der Lage, komplexe Aufgaben zu planen, zu strukturieren und durchzuführen, ohne dass alle Handlungsschritte vorher explizit vorgegeben sein müssen.

In modernen KI-Agenten übernehmen LLMs die Rolle des „Denkens“. Sie bewerten Situationen, schlagen Strategien vor und können eigenständig Handlungsschritte kombinieren.

Ein einfaches Beispiel verdeutlicht das Prinzip: Ein LLM-basierter Kalender-Agent erhält das Ziel, einen gemeinsamen Termin für fünf Personen zu finden. Er durchsucht selbstständig deren Kalender, erkennt Konflikte, schlägt Alternativen vor und sendet schließlich eine Einladung mit vorbereiteten Unterlagen aus, ohne dass ein Mensch jeden Zwischenschritt vorgeben muss.

Diese Fähigkeit, eigenständig zu planen und zu handeln, macht LLM-KI-Agenten so mächtig und erklärt, warum sie derzeit im Mittelpunkt der Aufmerksamkeit stehen.

Technisch gesehen verbinden sie zwei Welten:

- die klassische Agenten-Architektur (Wahrnehmung, Entscheidung, Handlung)

- und die kognitive Flexibilität von Sprachmodellen für komplexe Aufgaben

Wenn heute also von KI-Agenten die Rede ist, meint man in den meisten Fällen genau diese neue Generation von LLM-KI-Agenten, Systeme, die durch natürliche Sprache gesteuert werden, eigenständig handeln und in der Lage sind, ganze digitale Arbeitsprozesse zu übernehmen.

Im weiteren Verlauf betrachten wir deshalb ausschließlich solche LLM-basierten Agenten und zeigen, warum sie als zentraler Baustein der nächsten Automatisierungswelle gelten.

4. Warum werden KI-Agenten für Unternehmen so relevant?

KI-Agenten faszinieren, weil sie etwas leisten, das bisher Menschen vorbehalten war: autonomes, zielgerichtetes Handeln. Sie erledigen Aufgaben nicht nur nach festen Regeln, sondern können selbstständig entscheiden, wie sie ein Ziel am besten erreichen.

LLMs als „Gehirn“ moderner KI-Agenten

In dieser Fähigkeit liegt ihr enormes Potenzial. Denn nahezu jede digitale Aufgabe, die heute noch von Menschen ausgeführt wird, vom Sichten von E-Mails über die Erstellung von Berichten bis hin zur Vorbereitung von Meetings, lässt sich theoretisch auch durch einen KI-Agenten übernehmen. Und das rund um die Uhr, ohne Pausen, mit gleichbleibender Qualität und in einem Bruchteil der Zeit.

Für Unternehmen eröffnet dies weitreichende Chancen. KI-Agenten können:

- Routinearbeiten automatisieren, etwa das Erstellen, Sortieren und Zusammenfassen von Dokumenten,

- Informationen und Wissen effizienter verknüpfen, z. B. indem sie relevante Inhalte aus verschiedenen Datenquellen zusammentragen,

- Abläufe beschleunigen, etwa durch eigenständige Vorbereitung von Projekten, Angeboten oder Präsentationen,

- und Mitarbeiter entlasten, damit diese sich auf kreative, strategische oder zwischenmenschliche Aufgaben konzentrieren können.

Ein anschauliches Beispiel:

Ein Vertriebs-Agent könnte:

- eingehende Kundenanfragen automatisch priorisieren,

- passende Informationen aus dem CRM-System abrufen,

- personalisierte Antwortvorschläge generieren

- und offene Punkte an den zuständigen Miterbeiter weiterleiten.

Diese Kombination aus Autonomie und Zusammenarbeit macht KI-Agenten zu einem der vielversprechendsten Werkzeuge der kommenden Jahre.

Zusammenarbeit zwischen Mensch & Maschine

Gleichzeitig verändert sich damit auch die Rolle des Menschen. Während klassische Automatisierung vor allem auf Effizienz und Wiederholbarkeit abzielte, steht bei agentischen Systemen die Kooperation zwischen Mensch und Maschine im Vordergrund. Menschen definieren Ziele und Rahmenbedingungen, die Agenten übernehmen die operative Umsetzung. Diese Kombination aus Autonomie und Zusammenarbeit macht KI-Agenten zu einem der vielversprechendsten Werkzeuge der kommenden Jahre.

5. Wo sind Herausforderungen und Risiken von KI-Agenten?

Die zuvor beschriebenen Möglichkeiten werfen eine ganze Reihe von technischen, philosophischen, moralischen, juristischen und sozialen Fragen auf, auf die hier kaum eingegangen werden kann. Die unmittelbar relevantesten Herausforderungen sind technischer und juristischer Natur.

Technische Grenzen (Halluzinationen, Fehlentscheidungen)

LLMs sind letztendlich Computersysteme, die mit Wahrscheinlichkeiten arbeiten und daher unerwartete und unrichtige Antworten liefern können, das sogenannte Halluzinieren. Trotz aller technischen Fortschritte handelt es sich dabei noch immer um ein ungelöstes (und vielleicht ein inhärentes) Problem. Ist dies bei einem Chat mit einem LLM ein Ärgernis, kann es in einem KI-Agenten, der autonom weitreichende Entscheidungen treffen kann, verheerende Auswirkungen haben. Angefangen von unpassenden E-Mails über fehlerhafte Bestellungen mit Millionenbeträgen bis hin zur Gefahr für Leib und Leben.

Das führt unmittelbar zu juristischen bzw. Compliance-Problemen: Wer übernimmt die Verantwortung für ein System, das autonom agiert und Schaden anrichtet?

Warum menschliche Aufsicht unverzichtbar bleibt

Aus diesen Gründen ist ein komplett autonomer Betrieb von KI-Agenten mit maximalen Freiheiten momentan nicht möglich bzw. nicht wünschenswert. Um dennoch das enorme Potenzial nutzen zu können sind gewisse Sicherheitsmechanismen erforderlich, die einerseits dem KI-Agenten so viel Freiraum wie möglich lassen, um geforderte Aufgaben zu erfüllen und andererseits einen Schaden im Worst Case so gering wie möglich halten. Intensive praktische und theoretische Forschung auf diesem Gebiet erlaubt mittlerweile mächtige KI-Agenten, aber weiterhin mit menschlicher Aufsicht.

6. RAG & Agentic RAG – KI-Agenten in der Praxis

Eine besonders nützliche und gut zu kontrollierende Anwendung von KI-Agenten findet sich in RAG-Systemen. Hierzu ist es nützlich, sich die Evolution, wie LLMs verwendet werden, anzusehen.

Klassisches RAG vs. modernes RAG

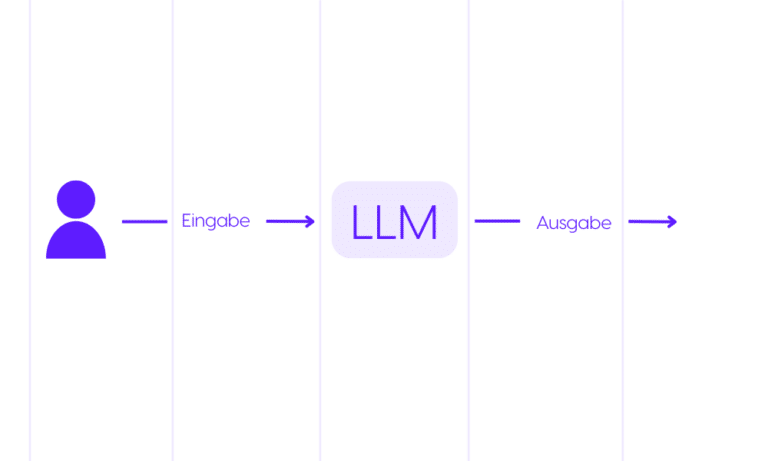

Zu Beginn, d.h. Ende 2022, wurden LLMs in erster Linie als einfache Chatbots, allen voran ChatGPT, genutzt. Das heißt, eine Nutzereingabe wurde direkt vom LLM in eine Antwort übergeführt. Was an sich eine beeindruckende Leistung ist, stieß bald an Grenzen, da LLMs inhärente Wissensbeschränkungen unterworfen sind. LLMs werden auf eine sehr großen, aber zeitlich begrenzten Datensatz trainiert. D.h. Ereignisse, die nach dem Training stattgefunden haben, sind prinzipiell für ein LLM unbekannt (“Wer hat gestern die Wahlen gewonnen?”).

Weiters beinhaltet der Trainingsdatensatz auch keine firmeninternen oder andere nicht öffentliche Daten. Somit werden Fragen wie “Wie ist die Regelung zum Zeitausgleich in meiner Abteilung?” zu keiner oder keiner sinnvollen Antwort führen.

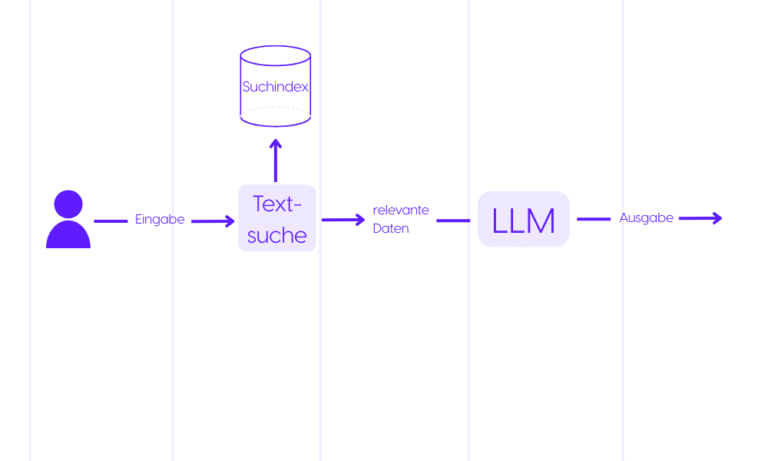

Aus dieser Not entstand das “klassische RAG”, bei dem das LLM mit deinem Datenspeicher gekoppelt wird. RAG steht für “Retrieval Augmented Generation” und bedeutet, dass bevor das LLM eine Antwort generiert, relevante Daten aus dem Datenspeicher (in vielen Fällen mit einer Textsuche) gesucht und zusätzlich zur Frage als unterstützenden Kontext an das LLM weitergeleitet werden, um eine Antwort zu generieren. Zeitlich aktuelles Wissen oder firmeninternes Wissen, wird hiermit dem LLM zugänglich gemacht.

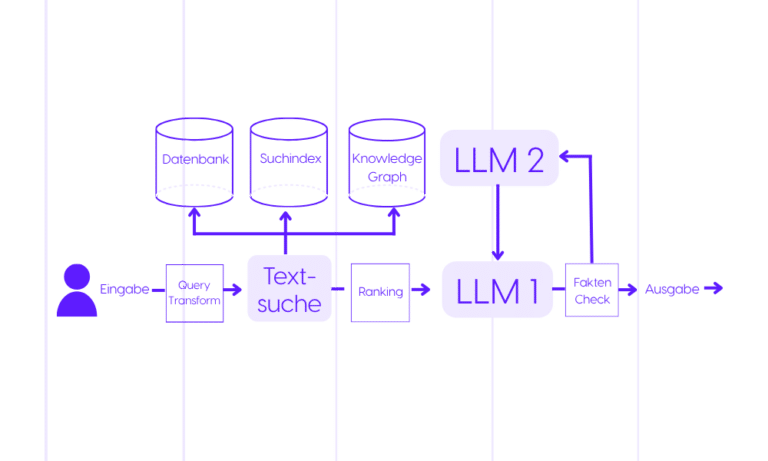

Viele weitere Module wurden im Laufe der Zeit entwickelt und zu diesem RAG-System hinzugefügt, was zum “modernen RAG” führte. Hierbei werden viele verschiedene Datenspeicher, LLMs und andere Module ausgeführt, um zur bestmöglichen Antwort zu gelangen. Dies erfolgt starr, in dem Sinne, dass von der Nutzereingabe bis zur finalen Antwort, jedes Modul in einer bestimmten Reihenfolge durchlaufen wird. D.h. sowohl bei den einfachsten (“Bitte”, “Danke”, …), als auch bei komplexeren Eingaben (“Fasse alle Dokumente die Person A zugeordnet sind und seit 2 Jahren nicht mehr bearbeitet wurden zusammen.”) werden die gleichen Module in der gleichen Reihenfolge abgearbeitet, was im einfachen Fall überdimensioniert und im komplexeren Fall möglicherweise unterdimensioniert ist.

Agentic RAG als nächste Stufe der Automatisierung

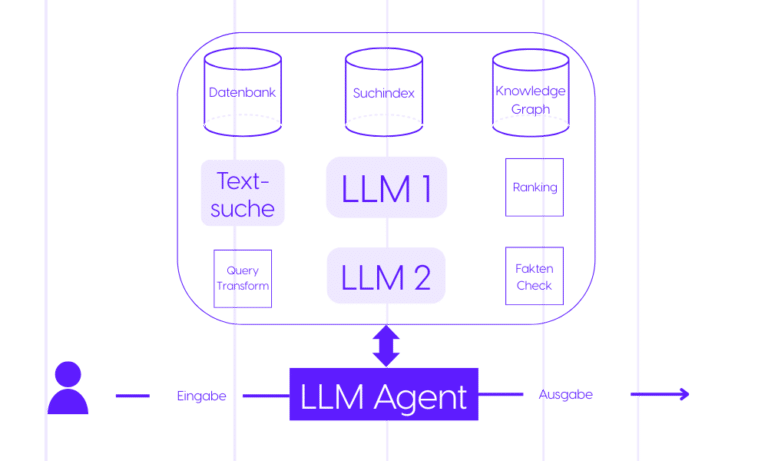

Dies führte zum “Agentic-RAG”, bei dem ein KI-Agent (LLM-Agent) die Steuerung aller Module übernimmt. D.h. der KI-Agent erhält die Benutzereingabe und die vorhandenen Module als seine Umgebung und führt diese in der Reihenfolge Schritt für Schritt aus um sein Ziel (die bestmögliche Antwort zu generieren) zu erreichen. Hiermit kann flexibel und autonom auf verschiedene Nutzereingaben reagiert werden: einfache Eingaben führen zu einfachen, komplexere Eingaben zu komplexeren “Workflows”. Der KI-Agent hat also Zugriff auf eine „Toolbox”, jedes “Tool” erfüllt eine klar definierte Aufgabe, die mit anderen „Tools” kombiniert werden kann. Der KI-Agent ruft diese relevanten “Tools” für die jeweilige Nutzereingabe in der richtigen Reihenfolge auf und führt die Ergebnisse zu einer kohärenten Antwort an den Nutzer zusammen.

7. Business Use Cases für KI-Agenten: MyGPT

MyGPT, als datenschutzsicheres RAG-System, setzt seit Anbeginn in Teilbereichen auf KI-Agenten, die je nach Nutzerpräferenz mehr oder weniger autonom handeln dürfen. Nutzer können mehr oder weniger strikte Rahmenbedingungen vorgeben, innerhalb derer der KI-Agent frei handeln darf. Hierdurch ist sichergestellt, dass je nach Kritikalität des Use Cases das volle Potenzial eines autonomen Systems, bei gleichzeitiger Wahrung aller Compliance-Richtlinien, genutzt werden kann.

Wissensmanagement & Dokumentenautomatisierung

Eine zentrale Stelle in MyGPT, bei der ein KI-Agent eingesetzt wird ist die Auswahl und Befragung verschiedener Wissensbasen.

MyGPT unterstützt die logische Gruppierung von Daten in Wissensbasen. Je nach Datentyp stehen unterschiedliche Arten der Befragung zur Auswahl: handelt es sich um natürliche Texte in PDF-Dokumenten kann eine Volltext- bzw. semantische Suche die passenden Teile finden, handelt es sich um Excel-Tabellen, können formelartige Abfragen durchgeführt werden (“Was ist die Differenz der Spalten A und D?”). Zusätzlich stehen viele weitere Typen von Abfragen zur Verfügung, z.B. strukturierte Suche im Inhaltsverzeichnis aller Daten oder eine Suche im WWW.

Diese führt zu einer Vielzahl an Möglichkeiten bei einer Nutzereingabe an relevante Informationen zu gelangen. Um die Nutzereingabe bestmöglich zu beantworten, muss je nach Inhalt dynamisch die passende Abfrage in der passenden Wissensbasis durchgeführt werden. Agentic-RAG hilft hier zielgenau nicht zu viel und nicht zu wenig Daten zu inkludieren, um den jeweiligen Use Case bestmöglich zu behandeln.

Konkretes Beispiel:

Fragt die Nutzerin beispielsweise nach einer tagesaktuellen Information, werden statische Wissensbasen ignoriert und es wird direkt eine Websuche durchgeführt. Wird hingegen nach betriebsinternen Arbeitsanweisungen gefragt, wird zuerst das Inhaltsverzeichnis der relevanten Wissensbasen durchsucht und basierend auf dem Ergebnis das relevante Dokument abgeholt.

Der KI-Agent in MyGPT beachtet in jedem Fall die nutzerdefinierten Beschränkungen, d.h., sind für gewisse Daten keine Berechtigungen vorhanden oder wird dem KI-Agenten die Websuche nicht gestattet, versucht das System ohne die Hilfe dieser Daten oder Module die bestmögliche Antwort im Rahmen der erlaubten Möglichkeiten zu generieren.

Ausblick und Fazit

Wie bei vielen Hype-Themen, ist es auch bei KI-Agenten schwer möglich das richtige Mittelmaß zwischen überzogenen Erwartungen und Pessimismus zu finden. KI-Agenten bieten prinzipiell ein nie dagewesenes Potenzial im Bereich der Automatisierung digitaler Arbeitsprozesse. Gleichzeitig stoßen einige Use Cases für KI-Agenten aber bereits an die technischen Limitationen, allen vor Halluzinationen.

Ein reales Beispiel zeigt wie nahe Frust und Chance bei diesem Thema beieinander liegen:

Microsoft startete ein Pilotprojekt, bei dem KI-Agenten Aufgaben in der Softwareentwicklung übernehmen. Trotz beeindruckender Leistung bei der Umsetzung gewünschter Features, wurden kleinere Fehler eingebaut, woraufhin menschliche Entwickler mit dem KI-Agenten in eine Diskussion traten mit der Anweisung die Fehler zu beheben. Es entspann sich ein hin und her, bei der jede Seite (KI vs. Mensch) überzeugt war im Recht zu sein.

MyGPT setzt daher auf einen hybriden Ansatz, Mensch und KI “Hand in Hand”. Menschliche Nutzer und Administratoren von MyGPT geben die Rahmenbedingungen vor, innerhalb derer sich KI-Agenten frei bewegen dürfen. Ja nach Use Case können diese Rahmenbedingungen strikter oder weniger strikt sein.

KI-Agenten markieren den nächsten logischen Schritt in der Evolution generativer KI: vom reaktiven Sprachmodell hin zu autonomen, zielgerichteten Systemen. Die Herausforderung liegt darin, das enorme Potenzial dieser Technologie verantwortungsvoll und mit menschlicher Expertise zu kombinieren.

Unternehmen, die Agentic AI strategisch einsetzen, werden nicht nur effizienter arbeiten, sondern auch neue Formen der Zusammenarbeit zwischen Mensch und Maschine etablieren. Genau hier liegt die Zukunft: nicht in der vollständigen Automatisierung, sondern in der intelligenten Koordination von KI-Agenten und menschlichem Wissen.

Mit diesem Verständnis entwickelt MyGPT seine Plattform konsequent weiter – als Werkzeug, das Organisationen befähigt, die Vorteile von KI-Agenten produktiv, sicher und transparent zu nutzen.

Mehr zu MyGPT

Mehr Details zum Einführungsprozess?

Laden Sie kostenlos unseren MyGPT Implementation Guide herunter – inklusive Schritt-für-Schritt-Anleitung und Anwendungsbeispielen.

Erstgespräch - Kostenlos & Unverbindlich

Wie könnte KI Ihren Arbeitsalltag erleichtern?

Sie möchten KI in Ihrem Unternehmen sinnvoll einsetzen, wissen aber noch nicht genau, wie? Oder Sie haben bereits eine Idee und suchen nach der passenden Lösung? Dann lassen Sie uns einfach mal reden. In einem kostenfreien Erstgespräch schauen wir gemeinsam, was für Sie sinnvoll ist – ganz ohne Verkaufsdruck, aber mit viel Erfahrung aus der Praxis.

Diese Unternehmen vertrauen

bereits auf Leftshift One

Häufig gestellte Fragen

Ein KI-Agent ist ein Computersystem, das seine Umgebung wahrnimmt, Entscheidungen trifft und handelt, um ein Ziel zu erreichen. Beispiele sind selbstfahrende Autos, digitale Assistenten oder Einkaufsagenten.

Chatbots reagieren meist nur auf einzelne Eingaben. KI-Agenten hingegen können eigenständig planen, mehrere Schritte kombinieren und komplexe Aufgaben erledigen. Sie arbeiten nach dem Prinzip Wahrnehmen – Entscheiden – Handeln.

Agentic AI beschreibt die neue Generation von KI-Agenten, die auf Large Language Models (LLMs) basieren. Diese Systeme nutzen natürliche Sprache, um Aufgaben zu verstehen, flexibel zu reagieren und Arbeitsprozesse zu automatisieren.

Unternehmen profitieren von KI-Agenten durch Zeitersparnis, Automatisierung von Routineaufgaben, besseres Wissensmanagement und höhere Effizienz. Mitarbeiter können sich dadurch stärker auf kreative und strategische Tätigkeiten konzentrieren.

Herausforderungen sind Halluzinationen (falsche Antworten), rechtliche Unsicherheiten und die Notwendigkeit menschlicher Kontrolle. Vollständig autonome Agenten sind aktuell noch riskant, daher empfiehlt sich ein hybrider Ansatz.

Ein Agentic RAG (Retrieval Augmented Generation) kombiniert LLMs mit Datenspeichern. Der KI-Agent entscheidet flexibel, welche Datenquellen oder Tools er nutzen muss, um die bestmögliche Antwort zu generieren.

MyGPT integriert KI-Agenten in seine RAG-Architektur. Nutzer können festlegen, wie autonom die Agenten handeln dürfen. So lassen sich datenschutzsicher Informationen aus Wissensbasen, Dokumenten oder Webquellen effizient verarbeiten.