AI Prompt Engineering: Die Sprache der KI meistern

Der Ultimative Guide für RAG-Systeme und mehr

Entdecken Sie in unserem ultimativen Guide, wie Sie mit Retrieval Augmented Generation und gezieltem AI Prompt Engineering KI-Tools effektiv in Ihrem Unternehmen implementieren können. Lernen Sie, präzise KI-Prompts zu erstellen, um Geschäftsprozesse nachhaltig zu optimieren und sich entscheidende Wettbewerbsvorteile zu sichern.

- 27. März. 2025

Karin Schnedlitz

Marketing Managerin

Sarah Bittermann

Junior Prompt Engineer

Die Zukunft der Unternehmenskommunikation

Stellen Sie sich ein neues Zeitalter der Unternehmenskommunikation vor – eines, in dem die präzise Kommunikation mit künstlicher Intelligenz (KI) zum entscheidenden Wettbewerbsvorteil wird.

Prompt Engineering ist ein Zukunftsskill, der nicht nur die Effizienz Ihrer Geschäftsprozesse steigert, sondern auch den ROI maßgeblich verbessert. Prognosen von Gartner zufolge werden bis 2025 über 80 % der Unternehmen Künstliche Intelligenz in ihre Prozesse integrieren – genau deshalb wird das Verständnis und die Beherrschung von effektivem Prompting zur Schlüsselkompetenz in jedem Unternehmen.

Dieser Artikel nimmt Sie mit auf eine Reise, bei der Sie lernen, die Sprache der KI zu sprechen, um Ihre Geschäftsprozesse nachhaltig zu optimieren.

Warum präzises KI-Prompting erfolgsentscheidend ist

Die Fähigkeit, KI-Modelle klar und zielgerichtet anzusprechen, entscheidet maßgeblich über den Erfolg Ihrer Vorhaben. Durch konkrete, kontextreiche Anweisungen erhält die künstliche Intelligenz die optimale Grundlage, um effizient und präzise zu agieren – was letztlich zu besseren Ergebnissen und einem nachhaltigen Wettbewerbsvorteil für Ihr Unternehmen führt.

Grundlagen des Prompt Engineerings für Generative KI

Was ist Prompt Engineering?

AI Prompt Engineering geht weit über das einfache Stellen von Fragen hinaus. Ein Prompt ist eine präzise formulierte Eingabeaufforderung, die KI-Modellen den optimalen Handlungsrahmen vorgibt. Beim Prompting handelt es sich um einen iterativen Interaktionsprozess mit einem KI-Tool, dessen Ziel es ist, klar definierte Aufgaben bestmöglich zu lösen. Dieser Ansatz ermöglicht es, die Leistungsfähigkeit generativer künstlicher Intelligenz voll auszuschöpfen.

Betrachten Sie den Unterschied:

- Unpräziser Prompt: „Schreib mir was über Marketing.“

- Präziser Prompt: „Erstelle einen detaillierten Marketing-Plan für ein B2B-SaaS-Startup, der ein Jahresbudget von 50.000 € berücksichtigt, in Quartale unterteilt ist und messbare KPIs enthält.“

Dieser Vergleich verdeutlicht, dass detaillierte Prompts entscheidend sind, um die Qualität der KI-generierten Outputs zu maximieren. Prompting ist ein Zukunftsskill, der es ermöglicht, mit gezielten Anweisungen schneller präzisere und relevantere KI-Outputs zu erzielen.

Die Kunst besteht darin, Details, Kontext und Zielsetzung so zu kombinieren, dass die künstliche Intelligenz die Anfrage optimal verarbeiten kann – sei es beim Einsatz von generativer KI oder beim Abrufen unternehmenseigener Daten in RAG-Systemen (Retrieval-Augmented Generation).

Durch präzise Anweisungen und einen klaren Kontext in Ihrer Anfrage minimieren Sie Missverständnisse und KI-Halluzinationen. So optimieren Sie Ihre KI-generierten Antworten mithilfe gezielten Promptings. Je genauer Ihre Prompts formuliert sind, desto hochwertiger sind die Ergebnisse die Sie von KI-Systemen erhalten – sei es bei kreativen Aufgaben wie Text- und Bilderstellung oder bei analytischen Aufgaben wie der Verkaufszahlenanalyse in RAG-Systemen.

Anwendungsbereiche der Generativen KI

Die Einsatzmöglichkeiten von Generative AI (GenAI) sind vielfältig und prägen die moderne Arbeitswelt zunehmend.

Ob Texterstellung (Text-to-Text), Bildgenerierung (Text-to-Image), Sprachverarbeitung (Text-to-Speech) oder Codeentwicklung – mit GenAI lassen sich kreative Prozesse beschleunigen, Routineaufgaben automatisieren und innovative Ideen realisieren.

Texterstellung: Marketing, Drehbücher und mehr

Von Marketingtexten über Drehbücher und Gedichte bis hin zu Übersetzungen und umfassenden Zusammenfassungen – generative KI revolutioniert die Arbeit von Kreativen und Content-Teams. Durch effektives Prompting steigert GenAI zudem die Effizienz in der Content-Produktion und beschleunigt kreative Arbeiten und erleichtert Brainstormings.

Bildgenerierung für Marketing und Design

Dank KI-basierter Bild- und Grafikentwicklung entstehen einzigartige Designs für Marketing, Kunst und Produktentwicklung, was insbesondere in Kreativbranchen einen klaren Wettbewerbsvorteil bedeutet.

Codeentwicklung: Automatisierung und Debugging

Mit Hilfe von Künstlicher Intelligenz werden repetitive Aufgaben automatisiert, Fehler minimiert und zugleich Softwareentwicklung sowie Debugging beschleunigt.

Um das volle Potenzial von KI-Tools auszuschöpfen, ist durchdachtes KI-Prompting unerlässlich. Nur so erzielen Sie schnell präzise Ergebnisse und nutzen die umfassenden Vorteile von generativer künstlicher Intelligenz optimal.

Best Practices im Prompt Engineering: Ihr Kompass zum Erfolg

Um den effektiven Einsatz von GenAI sicherzustellen, müssen beim Prompting von KI typische Herausforderungen überwunden werden:

- Mangelnder Kontext:

Einfache Stichworte sind in der Regel nicht ausreichend. Stattdessen helfen vollständige Sätze und aussagekräftige Hintergrundinformationen, dabei eine klare Richtung vorzugeben und so passgenaue KI-Outputs zu erhalten. - Bereits kleine Ungenauigkeiten oder Doppeldeutigkeiten können KI-Modelle in die Irre führen und minderwertige Ergebnisse erzeugen. Da Sprache oft komplex ist, lohnt es sich, mit verschiedenen Formulierungen zu experimentieren, um die Sprachmodelle optimal anzuleiten.

- Überladene Prompts:

Sind zu viele Informationen in einem einzelnen Prompt enthalten, können LLMs leicht in Fehlinterpretationen verfallen. Es ist daher ratsam, umfangreiche Anforderungen in einzelne, gut strukturierte Teilaufgaben aufzuteilen und diese nacheinander an die KI zu übermitteln. Dieser iterative Prozess führt zu präziseren und erfolgreicheren Ergebnissen.

Wer diese Hürden im Blick behält, legt den Grundstein für ein effizientes Zusammenspiel zwischen Mensch und KI.

Drei Schritte zum optimalen Prompt

- Klare Zielsetzung:

Definieren Sie präzise, welche Aufgaben die KI übernehmen soll und in welchem Format (z. B. Tabelle, Liste oder Fließtext) das Ergebnis erwartet wird. So minimieren Sie Interpretationsspielräume und stellen sicher, dass das LLM die wesentlichen Informationen klar und kompakt erhält. - Kontext einbinden:

Stellen Sie alle wichtigen Hintergrundinformationen bereit – beispielsweise relevante Dokumentenstrukturen oder branchenspezifische Fachbegriffe. So schaffen Sie ein Umfeld, in dem die KI zielgerichtet arbeiten kann. Achten Sie darauf, Mehrdeutigkeiten zu vermeiden und übermitteln Sie ausschließlich den relevanten Kontext, der für die erfolgreiche Bewältigung der Aufgabe notwendig ist. - Iteration:

Beginnen Sie mit einer allgemeinen Anfrage an das Sprachmodell und verfeinern Sie diese Schritt für Schritt. Ein Unternehmen könnte beispielsweise zunächst die Verkaufszahlen im Allgemeinen analysieren und sich anschließend gezielt auf saisonale Schwankungen oder bestimmte Produktlinien konzentrieren.

Durch die konsequente Anwendung dieser Techniken erzielen Sie präzise, verlässliche KI-Antworten, nutzen die Potenziale von Large Language Models (LLMs) optimal aus und erhöhen damit gleichzeitig die Effizienz Ihrer digitalen Prozesse.

Prompt Engineering für RAG-Systeme

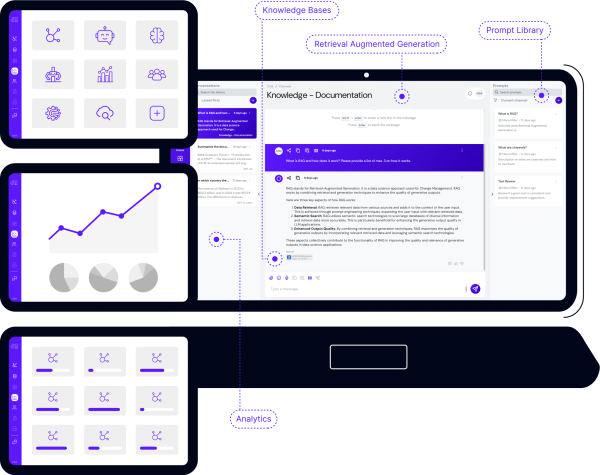

Während klassische Large Language Models (LLMs) oft schon mit umfangreichem Hintergrundwissen trainiert sind, stellt die Einbindung unternehmenseigener Daten in RAG-Systemen (Retrieval-Augmented Generation) eigene Anforderungen an das Prompt Engineering von KI-Modellen.

RAG-Systeme ermöglichen eine zielgerichtete Nutzung unternehmenseigener Dokumente und Datenbanken. Dadurch werden die KI-generierten Antworten präziser und bieten einen signifikanten Mehrwert für unternehmensinterne Use Cases.

Gezielte Datenabfrage im Unternehmenskontext

Durch einen gezielten, strukturierten Ansatz lässt sich sicherstellen, dass künstliche Intelligenz sowohl die richtigen Daten als auch den nötigen Kontext erhält.

Im Folgenden finden Sie vier Kernaspekte, um das volle Potenzial von RAG-Systemen auszuschöpfen.

1. Datenkenntnis: Die Macht der Struktur

Der wichtigste Grundsatz im RAG-Prompting ist das Verständnis für die zugrunde liegende Dokumentenstruktur.

- Spezifische Verweise:

Beziehen Sie sich in Ihren Prompts auf konkrete Überschriften, Abschnitte und Kapitel. - Hierarchien nutzen:

Profitieren Sie von klar strukturierten Dokumenten, um die KI mit Hilfe des Promptings zielgerichtet zu lenken. - Strukturierter Kontext:

Formulieren Sie Ihre Eingabeaufforderung so, dass sie den Aufbau der Dokumente berücksichtigen.

Beispiel:

Statt allgemein zu fragen: „Was sind unsere Verkaufszahlen?“ bietet es sich an, konkret zu werden:

„Welche Verkaufszahlen werden im Abschnitt ‚Q4 Performance Review‘ für die Premium-Produktlinie aufgeführt?“

2. Präzision durch Fachsprache

Die Wahl der richtigen Sprache ist essenziell, um präzise Ergebnisse zu erhalten:

- Branchenspezifische Fachbegriffe:

Nutzen Sie die Terminologie Ihres Fachgebiets. - Unternehmensinterne Bezeichnungen:

Achten Sie auf klare Produktnamen oder interne Kategorisierungen. - Exakte Formulierungen:

Je präziser Sie den Kern Ihrer Anfrage treffen, desto brauchbarer sind die Resultate.

Beispiel:

Statt zu fragen: „Wie läuft das neue Produkt?“ verwenden Sie besser:

„Wie entwickelt sich der Marktanteil unserer Enterprise-Suite ‚CloudMaster Pro‘ im B2B-Segment?“

3. Kontext ist König: Der Schlüssel zu präzisen Antworten

Ein reichhaltiger Kontext ist essenziell für den Erfolg von RAG-basierten KI-Anwendungen:

- Relevante Hintergrundinfos:

Definieren Sie den inhaltlichen Rahmen präzise, in dem das Modell arbeiten soll, um gezielte und konsistente Ergebnisse zu erzielen. - Genaue Spezifizierung:

Geben Sie klar an, auf welche Aspekte und Details sich die Antwort fokussieren soll – so erhalten Sie maßgeschneiderte Resultate. - Iterative Vertiefung:

Falls die erste Antwort des Sprachmodells nicht Ihren Erwartungen entspricht, stellen Sie gezielte Folgefragen, um das Thema weiter zu verfeinern. Starten Sie mit einem groben Konzept und optimieren Sie es im Verlauf der Konversation.

Beispiel:

Erster Prompt: „Analysiere die Kundenakquise-Kosten für unsere Enterprise-Kunden im DACH-Raum.“

Follow-up: „Fokussiere dabei besonders auf die Lead-Generierungskosten über LinkedIn-Kampagnen im Vergleich zu direkten Vertriebsaktivitäten.“

4. Erläuterungen in Daten: Klarheit schaffen durch Akronyme und Abkürzungen

Ein professioneller Umgang mit Abkürzungen und Akronymen macht den entscheidenden Unterschied in RAG-basierten Systemen. Präzise Erläuterungen stellen sicher, dass Large Language Models (LLMs) die verwendeten Kürzel korrekt interpretieren und verarbeiten:

- Relevante Kürzel einführen:

Erklären Sie eindeutig, wofür die Abkürzungen stehen, damit LLMs diese korrekt verarbeiten können. Dies verbessert die Datenqualität und die Genauigkeit der generierten Ergebnisse. - Konsistenz:

Nutzen Sie einheitliche Begriffe und Abkürzungen in Ihren Daten und Prompts, um eine zuverlässige und konsistente Verarbeitung in RAG-basierten Systemen zu gewährleisten. - Firmeninterne Akronyme:

Inkludieren Sie unternehmensspezifisches Fachwissen im Prompt, um gezielt nach Informationen zu suchen und optimale Ergebnisse zu erzielen.

Beispiel:

„Analysiere die KPIs unserer CSMs (Customer Success Manager) in Bezug auf die NRR (Net Revenue Retention) bei Enterprise-Kunden. Dabei steht CSM für unser Customer Success Management Team, das für die Kundenbindung verantwortlich ist.“

Künstliche Intelligenz, Sprachmodelle und Prompt Engineering: Mehr als Keywords

Deep Learning bildet das „Gehirn“ moderner KI-Systeme, während Prompt Engineering die präzise Sprache ist, die diese Systeme optimal steuert. Durch gezielte Anweisungen verwandelt sich eine einfache Eingabe in eine kontextbasierte Interaktion, die echten Business Value generiert.

Im Gegensatz zur klassischen Stichwortsuche, die lediglich Keywords abfragt, ermöglicht Prompt Engineering in RAG-Systemen und GenAI-Anwendungen, wesentlich mehr Kontext und Intention zu berücksichtigen. Wer sich ausschließlich auf Stichworte verlässt, verschenkt Potenzial, da die Nuancen der menschlichen Sprache und die Datengrundlagen in RAG-Systemen nicht optimal ausgeschöpft werden können.

Prompt Engineering ist die präzise Kommunikation mit KI, bei der Sie exakt definieren, was Sie wissen möchten – inklusive Detailgrad und Themenbereich. So wird aus einer simplen Suche eine zielgerichtete, kontextbasierte Interaktion mit einem KI Modell, die echte Mehrwerte für Unternehmen schafft und Ihre Wettbewerbsfähigkeit in der digitalen Ära stärkt.

Generative KI ist mehr als nur ein temporärer Trend. Sie avanciert zu einer Schlüsseltechnologie, die in immer mehr Unternehmensbereichen Anwendung findet.

AI-Prompt-Engineering im Alltag: Von der Idee zum erfolgreichen Business Case

Betrachten Sie Prompt Engineering als spannenden Prozess:

Am Anfang steht die Vision, Generative KI als kreativen und strategischen Partner im Unternehmen zu etablieren. Mithilfe von effektivem Prompt Engineering verwandeln Sie unscharfe Ideen in klare Konzepte – von der Ideengenerierung bis hin zur Umsetzung konkreter Maßnahmen. Ein strukturierter Ansatz steigert hier nicht nur die Effizienz, sondern spart auch Kosten und erhöht die Qualität der Ergebnisse.

Beispiel:

Marketingplan mit messbaren KPIs: Ein Marketing-Team nutzt präzise Prompts, um einen umfassenden, budgetierten Marketingplan zu erstellen, der in Quartale unterteilt ist und messbare KPIs liefert.

Die Wahl des richtigen KI-Modells

Da sich die KI-Landschaft rasant entwickelt, sind kontinuierliche Weiterbildung und regelmäßige Aktualisierung Ihrer Kenntnisse im Bereich generativer KI unerlässlich. Aktuell dominieren drei große Anbieter den Markt:

- OpenAI’s GPT-Modelle: ChatGPT ist vielseitig und leistungsstark, ideal für komplexe Aufgaben und kreative Anwendungen.

- Googles Gemini: Multimodal und perfekt in Google-Dienste integriert, besonders nützlich für Anwendungen, die Bild-, Text- und Audiodaten kombinieren.

- Anthropics Claude-Modelle: Ethisch orientiert und spezialisiert auf lange, nuancierte Texte sowie komplexe Dialoge.

Bei der Auswahl eines KI-Modells sollten Sie vor allem folgende Kriterien beachten:

- Benötigte Präzision und Genauigkeit

- Verarbeitungsgeschwindigkeit und Latenz

- Kosten und Lizenzmodelle

- Datenschutz und Transparenz (insbesondere wichtig bei sensiblen Unternehmensdaten)

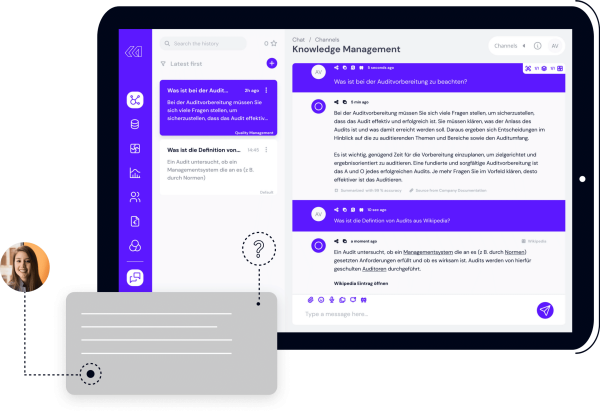

MyGPT: Die flexible KI-Alternative zu ChatGPT und Co.

Eine innovative Möglichkeit stellt die Nutzung spezialisierter RAG-Lösungen wie MyGPT von Leftshift One dar. MyGPT bietet eine datenschutzkonforme GenAI-Lösung, die flexibel auf die sich ständig wandelnden Anforderungen von Unternehmen reagiert. Unternehmen profitieren dabei von einer sicheren Anbindung unterschiedlicher KI-Modelle mit Hosting innerhalb der EU sowie der Möglichkeit, Datenquellen stets aktuell zu halten. Ob technischer Support der Mitarbeiter, Unterstützung bei administrativen Aufgaben, Onboarding oder Schulungsprozessen oder der einfachen Texterstellung – MyGPT ermöglicht es Unternehmen, das volle Potenzial großer Sprachmodelle intern zu nutzen, dabei stets die Kontrolle über Kosten, Verwendung und Datenquellen zu behalten und klar festzulegen, welche Modelle von welchem Anbieter für welchen konkreten Zweck eingesetzt werden.

Neue Horizonte mit Reasoning Modellen

Neben den bekannten General Purpose LLMs, wie den GPT-Modellen von OpenAI, gewinnen spezialisierte Reasoning-Modelle – beispielsweise GPT-o1, o3-mini, Gemini Flash Thinking, Claude 3.7 Sonnet und DeepSeek R1 – zunehmend an Bedeutung. Diese fortschrittlichen Modelle erweitern die Einsatzmöglichkeiten generativer künstlicher Intelligenz und ermöglichen eine präzisere und kontextbasierte Entscheidungsfindung, die neue Maßstäbe in der KI-Anwendung setzt.

Sie sind besonders hilfreich, wenn es um komplexe Entscheidungsprozesse oder strategische Analysen geht:

- Komplexe Entscheidungsprozesse:

Durch mehrstufiges „Denken“ und schrittweise Analyse liefern sie detaillierte Handlungsempfehlungen. - Strategische Planung:

Sie helfen beim Durchspielen unterschiedlicher Szenarien und beim Abwägen von Vor- und Nachteilen. - Fehlerdiagnose:

Mit gezieltem Prompting lassen sich Probleme ermitteln und passende Lösungen ableiten.

Effizienz, Innovation und Kundenzufriedenheit durch gezieltes Prompting

Ob Ideengenerierung, automatische Korrektur, E-Mail-Erstellung oder SEO-Optimierung – Prompt Engineering bietet in allen Bereichen einen enormen Mehrwert.

Eine Studie von McKinsey zeigt, dass der gezielte Einsatz von Generative AI in der Ideengenerierung die Innovationsrate erheblich steigern kann. Unternehmen profitieren zudem von schnelleren Entscheidungen, optimierten Abläufen und einer verbesserten Kundenzufriedenheit.

Beispiele aus der Praxis

- Ideengenerierung:

Steigern Sie Ihre Innovationsrate und fördern Sie kreative Lösungsansätze – beispielsweise entwickeln Marketingteams mit präzisen Prompts passgenaue Kampagnen. - Textzusammenfassungen:

Optimieren Sie Ihr Zeitmanagement und gewinnen Sie schnell fundierte Informationen durch kompakte, KI-generierte Zusammenfassungen umfangreicher Inhalte. - Automatische Korrektur:

Verbessern Sie die Qualität Ihrer Texte durch automatisierte Rechtschreib- und Grammatikprüfungen, die konsistente und fehlerfreie Dokumente ermöglichen. - Informationsextraktion:

Extrahieren Sie zielgerichtet relevante Daten aus umfangreichen Dokumenten und Datenbanken, um fundierte Entscheidungen zu treffen. - Mehrsprachige Übersetzungen:

Erweitern Sie Ihre globale Reichweite und verbessern Sie die Kommunikation durch präzise, KI-gestützte Übersetzungen in mehrere Sprachen.

Kontinuierliche Prozesse für nachhaltigen Erfolg

Die erfolgreiche KI Implementierung und effektives Prompt Engineering erfordert eine systematische Herangehensweise im Alltag:

Dokumenten-Vorbereitung

Eine effektive Vorbereitung beginnt mit einem Glossar zentraler Begriffe und Abkürzungen. So stellen Sie sicher, dass generative KI-Modelle Ihre unternehmensspezifische Sprache korrekt interpretieren und anwenden. Einheitliche Terminologie erhöht die Konsistenz und Qualität der erstellten Inhalte – besonders in komplexen Branchen oder bei rechtlich sensiblen Themen.

Qualitätssicherung durch menschliches Review

Verlassen Sie sich nicht blind auf KI-Antworten. Integrieren Sie einen klar definierten Review-Prozess, um die Qualität und Relevanz der generierten Inhalte zu gewährleisten. Kritisches Gegenlesen durch Fachkräfte ist essenziell, um Fehler, Missverständnisse oder fehlerhafte Kontexte frühzeitig zu erkennen und zu korrigieren.

Strukturierte Dokumentenprozesse etablieren

Definieren Sie klare Abläufe für die Erstellung, Bearbeitung und Archivierung von Dokumenten. Ein strukturierter Workflow erhöht die Effizienz, reduziert Risiken und unterstützt die Nachvollziehbarkeit – insbesondere im Teamkontext oder bei revisionsrelevanten Unterlagen.

Business Value und ROI durch effektives Prompt Engineering

Effizientes Prompt Engineering wirkt sich nicht nur auf die Qualität der KI-Outputs aus, sondern steigert auch den Return on Investment (ROI) und den Business Value für Ihr Unternehmen. Deloitte (2023) zeigt, dass gut durchdachte Prompting-Strategien die Kosten von KI-Projekten um bis zu 40 % senken können.

Wichtige KPIs und Erfolgsfaktoren:

- Präzision und Relevanz der Antworten: Messbar durch Nutzerfeedback und Expertenbewertungen.

- Fehlerreduktion: Analyse von Fehlerquoten und Qualitätskontrollen.

- Effizienz der Wissensabfrage: Bewertung der Antwortzeiten und Ressourcennutzung.

- Nutzerzufriedenheit: Ermittelt durch Umfragen und Feedback-Analysen.

Durch präzise formulierte Prompts können Entwicklungs- und Arbeitskosten reduziert werden, da sich die Bearbeitungszeit einzelner Aufgaben verkürzt (Accenture, 2023). Zudem führt eine hohe Qualität der Prompts zu besseren KI-Ergebnissen, was sowohl die Akzeptanz als auch den Nutzen der KI-Anwendungen steigert.

Nutzer, die verlässliche und hilfreiche Ergebnisse erhalten, kehren eher zu einer Lösung zurück, während mangelhafte Outputs schnell zu Frustration führen und die Nutzungsbereitschaft senken (Stanford University, 2022).

Darüber hinaus ermöglichen gut gestaltete Prompts eine höhere Mitarbeiterproduktivität, da Informationen schneller gefunden und Aufgaben effizienter erledigt werden können.

Abschließend trägt gutes Prompting zu einer verbesserten Interaktion mit KI-Systemen und damit zu einer höheren Kundenzufriedenheit bei, da Kundenbedürfnisse besser erkannt und erfüllt werden können.

Durch effektives Prompt Engineering lässt sich in mehrfacher Hinsicht ein signifikanter Business Value erzielen:

- Der schnelle Zugriff auf relevante Informationen ermöglicht fundiertere und schnellere Entscheidungen, indem Wissenslücken rasch geschlossen werden.

- Unternehmen, die ihre RAG-Systeme durch gutes Prompting optimal nutzen, können neue Produkte und Dienstleistungen entwickeln und sich damit entscheidende Wettbewerbsvorteile sichern.

- Nicht zuletzt führen automatisierte Prozesse und eine effizientere Ressourcennutzung zu deutlichen Kosteneinsparungen und einer insgesamt gesteigerten Effizienz.

Fazit und Ausblick: Die Zukunft spricht KI

Die Reise in die Welt des Prompt Engineerings macht deutlich: Wer die Sprache der Künstlichen Intelligenz präzise beherrscht, legt den Grundstein für nachhaltigen Erfolg.

Ein fundiertes Verständnis der Grundlagen, ein strukturierter Ansatz zur Bewältigung von Herausforderungen und die ständige Weiterentwicklung Ihrer Prompting-Skills bilden das Fundament für erfolgreiche KI-Implementierungen und eine effiziente digitale Transformation sowohl für Unternehmen als auch für deren Mitarbeiter.

Praktische Tipps für Unternehmen

- Weiterbildung fördern:

Organisieren Sie Workshops und Online-Kurse rund um KI und Prompt Engineering, um Ihr Team stets auf dem neuesten Stand zu halten. - Best Practices etablieren:

Nutzen Sie unternehmensspezifische Templates für die Dokumenterstellung, setzen Sie auf iterative Review-Prozesse und legen Sie damit klare Standards für eine konsistente Qualität fest. - Strukturierte Prozesse:

Etablieren Sie ein professionelles Datenmanagement, um langfristig hochwertige Ergebnisse zu sichern und den Ressourceneinsatz zu optimieren. Nutzen Sie die Fähigkeiten der generativen KI um ihre Datenbasis oder interne Prozesse zu verbessern.

Weiterführende Ressourcen: Prompt Engineering Kurse, Trainings und Zertifizierungen

Für weiterführende Informationen zum Thema Prompt Engineering empfehlen wir Ihnen, auf bewährte Online-Ressourcen und spezialisierte Kurse zu setzen:

- Leftshift One Youtube: Ergänzend dazu liefern YouTube-Kanäle wie jener von Leftshift One oder Two Minute Papers inspirierende Einblicke und praktische Beispiele aus der Welt des Prompt Engineerings.

- Google AI Education: Entdecken Sie Anfänger- und Fortgeschrittenen-Kurse und Tutorials auf Google AI Education.

- Stanford Online: Bietet ebenso eine Fülle an qualitativ hochwertigen Kursen und Zertifizierungen, die Ihnen einen fundierten Einstieg in KI-Technologien ermöglichen.

- Deeplearning.AI: Werden Sie KI-Experte und erkunden Sie das vielfältige Kursangebot und Spezialiserungen für alle Skill-Levels zu unzähligen Themen.

Nutzen Sie diese Online-Ressourcen, um Ihr Wissen im Bereich Prompt Engineering und Künstliche Intelligenz kontinuierlich zu erweitern und sich optimal für die digitale Zukunft zu rüsten. Mit einem ganzheitlichen Ansatz sind Sie bestens vorbereitet, um sich im Wettbewerb durchzusetzen und die Potenziale moderner KI-Technologien voll auszuschöpfen.

Die Zukunft gehört denen, die die Sprache der KI nicht nur verstehen, sondern sie gezielt einsetzen, um innovative Lösungen zu entwickeln und Geschäftsprozesse effektiv zu optimieren. Setzen Sie das Potenzial des AI Prompt Engineerings in Ihrem Unternehmen ein und bleiben Sie am Puls der Zeit – denn die Welt der Künstlichen Intelligenz entwickelt sich rasant weiter. Prompt Engineering ist Ihr Schlüssel, diese Entwicklung aktiv mitzugestalten und nachhaltigen Erfolg zu sichern.

MyGPT Online Demo

Entdecken Sie MyGPT in einer exklusiven 60-minütigen Online-Demo

- Persönliche Führung: Ein MyGPT-Experte führt Sie durch die Software und zeigt Ihnen, wie MyGPT Ihr Unternehmen voranbringt.

- Fragen & Antworten: Stellen Sie live Fragen und erhalten Sie sofort Einblicke in MyGPT.

- Individuelle Einblicke: Sehen Sie, wie MyGPT speziell Ihrem Unternehmen nutzt und sich einfügt.

- Exklusive Vorstellung: Entdecken Sie maßgeschneiderte Funktionen und Anpassungen von MyGPT.

Diese Unternehmen vertrauen

bereits auf Leftshift One